斯坦福大学的Alpaca AI人在许多任务上的表现与惊人的ChatGPT相似,但它建立在一个开源的语言模型上,训练成本不到600美元。看来这些神一样的人工智能已经便宜得吓人了,而且很容易复制。

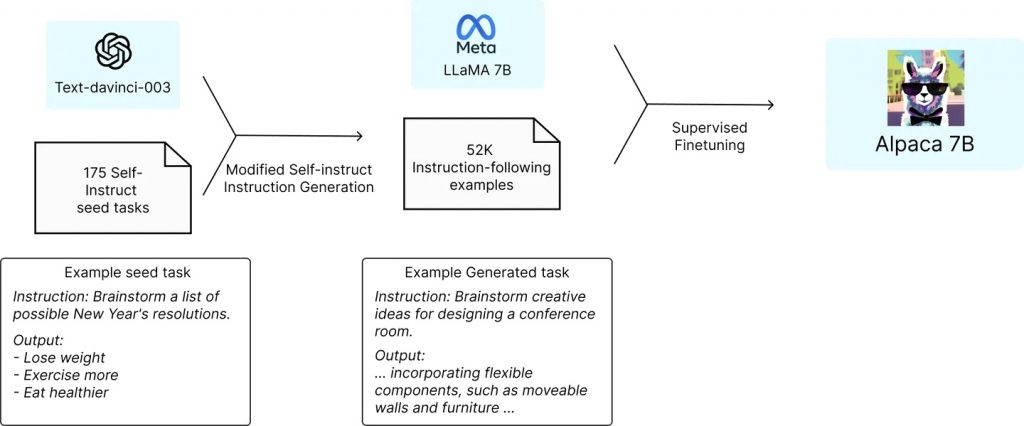

斯坦福大学的一个研究小组从Meta的开源LLaMA 7B语言模型开始,这是现有几个LLaMA模型中最小和最便宜的一个。在一万亿个“代币”上进行预训练,这个小语言模型有一定的能力,但它在大多数任务中明显落后于ChatGPT;GPT模型的主要成本,甚至主要竞争优势,主要来自OpenAI在后期训练中投入的大量时间和人力。读了十亿本书是一回事,但通过大量的问答式对话来教导这些AI的实际工作是另一回事。

因此,随着LLaMA 7B模型的建立和运行,斯坦福大学的团队基本上要求GPT采用175个由人类编写的指令/输出“组合”,并开始以同样的风格和格式生成更多的指令/输出对,每次20个。这是通过OpenAI帮助提供的一个API自动完成的,在很短的时间内,该团队有大约52,000个对话样本,用于后期训练LLaMA模型。生成这些大量训练数据的成本不到500美元。

然后,他们用这些数据来微调LLaMA模型,这个过程在8台80GB的A100云端处理电脑上花费了大约3个小时。这方面的花费不到100美元。

接下来,他们对产生的模型进行了测试,他们称之为Alpaca,与ChatGPT的底层语言模型在各种领域进行对比,包括电子邮件写作、社交媒体和生产力工具。在这些测试中,Alpaca赢得了90项,GPT赢得了89项。

“鉴于模型规模小,指令跟随数据量不大,我们对这一结果相当惊讶,”该团队写道。“除了利用这个静态评估集,我们还对Alpaca模型进行了交互式测试,发现Alpaca在不同的输入集上往往表现得与text-davinci-003 (GPT-3.5)类似。我们承认,我们的评估在规模和多样性方面可能是有限的”。

该团队继续说,如果他们寻求优化过程,他们可能会更便宜地完成这项工作。值得注意的是,任何希望复制人工智能的人现在都可以获得能力更强的GPT 4.0,以及几个更强大的LLaMA模型作为基础,当然也没有必要停留在52,000个问题。

斯坦福大学的团队在Github上发布了这项研究中使用的52,000个问题,以及生成更多问题的代码,以及他们用于微调LLaMA模型的代码。该团队指出,“我们还没有对Alpaca模型进行微调,使其安全无害”,并要求任何建立Alpaca模型的人报告他们发现的安全和道德问题。

那么,有什么可以阻止任何人现在花100美元左右创建他们自家的宠物人工智能,并以他们选择的方式训练它?尽管OpenAI的服务条款确实说 “你不能⋯⋯使用服务的输出来开发与OpenAI竞争的模型”。而Meta说它在现阶段只允许学术研究人员在非商业许可下使用LLaMA,尽管这是一个有争议的问题,因为整个LLaMA模型在公布一周后就在4chan网站上泄露了。

还有一个小组说它已经设法消除了云端计算成本,在Github上发布了更多的代码,可以在Raspberry Pi上运行,并在单个高端nVidia RTX 4090显卡上在5小时内完成训练过程。

这一切意味着现在可以建立无限数量的不受控制的语言模型,由具有机器学习知识、不在乎条款和条件或软件盗版的人建立。

这也给致力于开发自己语言模型的商业人工智能公司泼了一盆冷水;如果所涉及的大部分时间和费用都发生在训练后阶段,而这项工作或多或少可以在回答50或100,000个问题的时间内完成,那么公司继续花费这些现金是否有意义?

而对于我们其他人来说,这个软件的强大功能肯定可以为专制政权、网络钓鱼行动、垃圾邮件发送者或任何其他可疑的人所用。

“精灵已经从瓶子里出来了”,而且似乎已经非常容易复制和重新训练了,大家要站稳呀!

图片:Stanford University